信息论

信息论介绍

信源

编码器

信道

- 译码器

- 信宿

信息论的度量

I(X;Y):Y给X消除多少不确定性

H(X):X的不确定性

H(X|Y):有Y的时候,X的不确定性

在信道中

H(X|Y):损失熵

H(Y|X):噪声熵

互信息的对称性

性质

熵函数H的性质

对称性

确定性

非负性

扩展性

连续性

递推性 划分产生的不确定性

极值性 最大离散熵定理

上凸性

联合熵 二维随机变量

条件熵

三种熵关系

- 熵函数的链规则(相当于概率论里的乘法法则)

推广到N个随机变量:

概率空间 ·非负性 完备性

信源

平稳信源:概率分布与时间起点无关

平均符号熵 $H_N(X)=\frac{1}{N}H(X_1X_2···X_N)$

- 熵率(极限熵)$H_\infty$ $N->\infty$

平稳无记忆信源 $H(X1X_2···X_N)=N H(X)$ $H\infty=H(X)$

平稳有记忆信源 $H(X_1X_2···X_N)=H(X_1)+H(X_2|X_1)+···+H(X_N|X_1X_2···X_N)$

马尔可夫信源

- 马尔可夫信源的熵率

- 状态转移概率TP

- 极限熵

信道

两端信道

恒参信道(平稳)

随参信道(非平稳)

信道干扰对传输的影响

信道矩阵 上面的组成的矩阵

前向概率(先验概率):$p(y_i|x_i)$

后向概率(后验概率):$P(x_i|y_i)$

全概率公式: $P(x_i)=P(x_iy_1)+P(x_iy_2)+···$

信道容量

信道疑义度:$H(X|Y)$

信息传输率:$R=I(X;Y)$

信息传输速率:$\frac{R}{t}$

信道容量:

最佳输入分布:

- 无损信道:一对多

- 无噪信道:多对一

- 无噪无损信道:一对一

对称信道

行对称信道:每行元素相同,与第一行排列不同

对称信道:每行每列元素相同,与第一行第一列排列不同

准对称信道:满足行对称,但不满足对称,但可以分成若干对称子矩阵

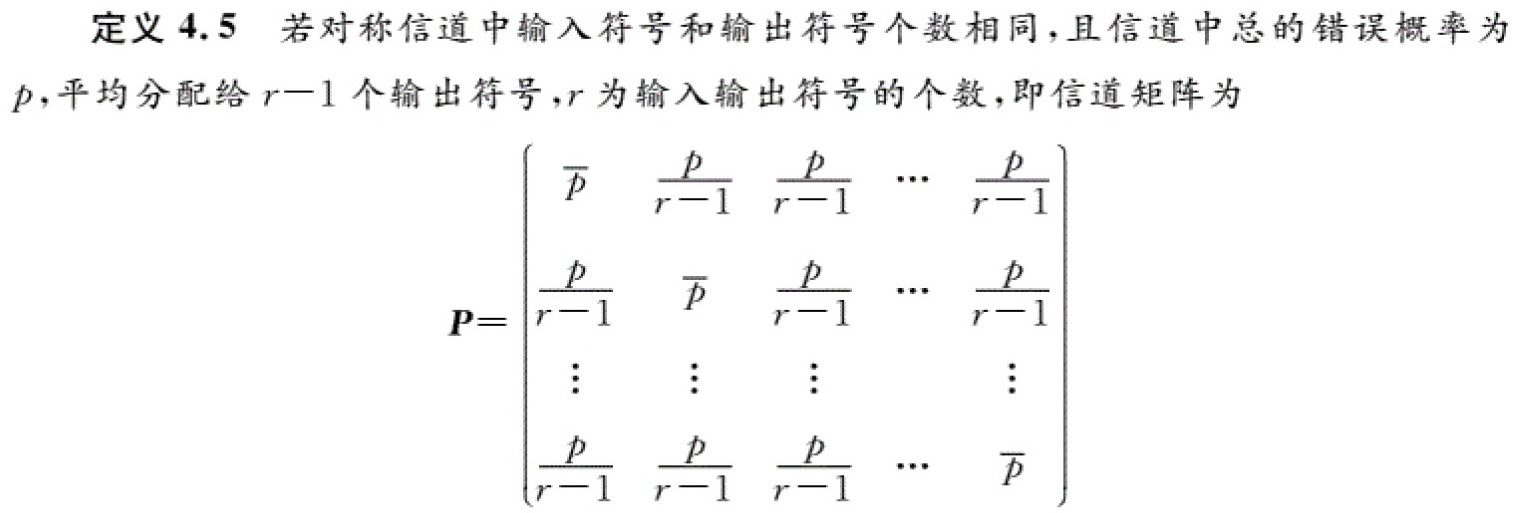

强对称信道(均匀信道):

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 Hexo!

评论